コラムCOLUMN

2023年展望~感情AIをめぐる最新動向

医療、ライフケアへの応用が進展

清水 計宏

教育分野への感情AI活用には賛否両論

人間のコミュニケーションの基本である言語は心から生まれ、発せられた言葉は心に返って理解される。思考・意志の働きをする心情やその動きである感情をコンピューターに理解させ、応答・反応させることは、研究者にとって過去数十年にわたって課題であった。

人間の心や感情をコンピューターで測定し、理解させて反応できるようにすることは、不確実性やプライバシー、人権の課題はあるものの、ようやく実用化レベルとなっている。

「感情AI(Emotional AI)」や「感情コンピューティング(Affective Computing)」と呼ばれる技術について、すでにイスラエルや中国を含めて、世界の先進的な企業をクローズアップした。今回も、その技術と周辺について、着目すべきトレンドを追った。

感情AIは、既述のようにAIを活用して、顔の表情、ジェスチャー(しぐさ・姿勢・態度)、音声、言葉(テキスト)、バイタルサインから個人や複数の感情を認識するシステムである。使用される技術は、マシンラーニング(機械学習)とそこに含まれるディープラーニング(深層学習)のほか、パターン認識ネットワーク、自然言語処理(NLP:(Natural Language Processing)などである。

もちろんその前提として、ビッグデータの母集団を丸ごと集計できるようになったことがある。集計や比較がしやすく、解析・分析に適した構造化データだけでなく、テキスト、音声、ビデオ、ログファイル、位置情報、センサー情報といった非構造化データまで扱えるようになった。

ビッグデータは、マクロ(集団)で取るか、ミクロ(個人)で集めるか、あるいはリアルタイムで取得するか、まとめてからバッチ的に処理するかといった方法がある。それらを組み合わせて、一定のパターンを見つけていく。ミクロの手法は、個人が特定されてしまうため、監視・セキュリティには向いているが、人権やプライバシーの観点からすると難点がある。こうした膨大なデータをAIでリアルタイムに分析することで、新たな発見や洞察、将来の予測につなげることができる。そのため、あらゆる領域で使われるようになっている。

教育分野でも導入が進んでいるが、問題も表面化している。例えば、2022年4月に米Intel(インテル)が、仮想空間で授業できるソフトを販売するClassroom Technologiesと提携して、学生の顔の表情から学習への取り組み状態を読み取る技術を導入した。これに対し、賛否両論が噴出した。「生徒が授業に退屈しない、大規模な個別指導が可能になる」と評価する一方で、人の能力や精神状態を見た目から推測するのは、生徒の監視や人権侵害の怖れがあると警鐘を鳴らす関係者もいる。

感情AIは、指数関数的に成長している技術のひとつである。だが、人を外観から識別するため、海外における抵抗感は、日本とは比べものにならないほど強い。特に先進国において、多宗教・多民族が共生しており、LGBTQ(Qは自分の性がわからない「Questioning」と性的少数者の「Queer」を表す)など性的マイノリティへの理解が求められ、身体・精神的障がい者の人権を守り、年齢、性別、国籍、学歴、職歴、人種、容姿の違いにかかわらず、人材の多様性が認められている。それを社会的に生かす「ダイバーシティ&インクルージョン(Diversity and Inclusion)」(社会的包摂)が規範となっているからだ。こうした課題においても、日本は先進的な少数の大企業を除けば、世界にかなり遅れをとっており、感情AIの論議が盛り上がらない一因にもなっている。

ヘルスケアとライフケアにも有益な感情AI

2023年に向けた感情AIのトレンドとして、好ましいこともある。それは、デジタルヘルスやヘルスケア、医療といった分野での活用が増えていることである。病院や医療施設にとどまらず、個人が自ら心身の健康やバイタルデータを管理しながら、最良の人生を送ろうとするライフケアの促進につながっている。

Web3にも見られるように、メディア環境は「分散化」「オンデマンド化」「パーソナライズ」へと進展している。接客や顧客サービスでも単なるCS(顧客満足)から一人ひとりに合わせたPS(パーソナル・サティスファクション)が求められている。

こうした波はライフケアにも着実に押し寄せている。AIや感情AIにおけるPros & Cons(長所と短所)でいえば、良い点を意味するPros(Proactive, Promotion, Protect)のひとつである。Cons(Conflict, Contradict, Contrast)は、これまでに、さまざま指摘してきたとおりである。

こうした流れは、バイタルデータを個人でも取得しやすくなったことが影響している。スマートウォッチを着用することが珍しくなくなり、医療用、デジタルヘルス用のウェラブルデバイスの装着にも抵抗感が少なくなった。心拍・脈拍、脳波、運動量、発汗、血圧といったセンサーで得られる身体の情報や情動が、個人で手軽に取得でき、スマートフォンで経過観察して、医療提供者とも共有できるようになった。

感情AIが、ヘルスケアのゲームチェンジャーの役割を果たしている。例えば、ストレス、不安、怒りなどの感情の変化は、妊娠期のリスク要因になりがち。感情AIが、妊娠中の女性の感情の状態を測定し、タイムリーに対処することで、女性を精神面からもサポートできる。世界保健機関(WHO)の統計によれば、開発途上国では、女性の約16%が妊娠中に、また出産後に20%がうつ病を経験している。妊娠中に約10%、第一子を生んだ母親の13% が精神障害に陥っている。

言葉や表情、視線、身振りなどから相手の感情を読み取ったり、自分の考えを伝えたりすることが不得手な自閉スペクトラム症(ASD:Autism Spectrum Disorder)の子どもたちにとって、感情AIとインタラクティブ・ビデオを組み合わせることで、相手の感情の動きを理解できるようになった。とかく孤独に陥りがちな高齢の患者にとっても、医師や看護婦がその心情を把握することにより、患者に寄り添い、孤立感を軽減することができる。

こうしたことは、AIとビッグデータが、人と人とのインタラクションをサポートし、実世界(フィジカル空間)のセンサーネットワークで多様なデータを収集することで、仮想世界(サイバー空間)において大規模データを処理して分析するサイバー・フィジカル・システム(CPS)の実例として捉えることができる。これは、内閣府の戦略的イノベーション創造プログラム(SIP)の目指すところでもある。

Hume AIの使命はAIで人間の幸福度を高めること

米ニューヨークを拠点に音声と非言語コミュニケーションにフォーカスしたAIスタートアップであるHume AI(ヒューム・エーアイ)=写真=は、自然言語処理のサブセットである自然言語理解(NLU:Natural Language Understanding)を使用して感情AIを開発している。これは、「Empathic AI」(共感型AI)と呼ばれ、人間の幸福度を高め、社会福祉に役立つAIをミッション(使命)としている。世界中から収集した膨大なデータを分析して、偏りがないラーニング・スキルモデルをベースにしているのが特徴。Hume AIは、いわゆるステルスモード(人から察知されない状態)で起業したため、明確に実態をつかみにくいところがある。この企業は、人間の表情や言葉(テキスト)、音声などをオーディオやビデオ(動画)、画像で取り込み、感情やそのほかの表現を把握するだけでなく、その意味を捉えようとする自然言語理解ツールを構築している。

マシンラーニング(機械学習)ツールを使うことで、患者の音声やスピーチをキャプチャーするだけで、うつ病、認知障害、苦痛などの状態を把握することができる。これは、単に音声をテキストに変換して、その意味や語句から判別しようとする自然言語理解モデルよりも高い精度になる。AIのバイアス(偏向)を取り除くことで、感情分析の従来の3倍の精度になるとしている。

一般的にAIの最大の問題は、データとアルゴリズムの偏りである。多様性のないビッグデータを使って AIアルゴリズムをトレーニングすると、それがバイアスになりがちである。それを世界中で利用されてスケーリングすると、そのバイアスは何千倍にも増幅する。このため、AIにもダイバーシティ(多様性)は欠かせない。

Hume AIのアルゴリズムは、ヘルスケア・ アプリケーションを使用した非言語コミュニケーションを評価するツール。そのアルゴリズムは、微妙なニュアンスのある 53の感情を理解するために、従来型の6つの基本的な感情モデル(怒り・嫌悪・恐怖・喜び・悲しみ・驚き)を退けている。

それは、差別、偏見、誤認識で収集してしまうデータバイアスを回避するためでもある。ただし、驚き、痛み、皮肉などの感情を記録して、あえぎ、ため息、笑い声などの音声をキャプチャーすることはできる。異なる文化圏の人たちの顔の表情から、細かな違いを解析した感情マッピングを作成することもできる。

Hume AIのプラットフォームを使用してSNSの投稿からユーザーの気分を測定し、アルゴリズムで調整して改善することを提案するようなサービスにも取り組もうとしている。

Googleの客員研究員だったアラン・コーウェンが設立

Hume AIは、2021年に心理学の研究者でありGoogleで客員研究員として働いたアラン・コーウェン(Alan Cowen)氏により設立された。コーウェン氏は、米カリフォルニア大学バークレー校で心理学の博士号を取得し、コンピューティングと人間の感情が交差する研究に携わった。1990年代から感情に関する研究を続け、データドリブンな人間の経験と表現を研究する方法を見出そうとしてきた。

その中で世界中の何万人もの感情刺激に対する反応を調査し、磁気共鳴機能画像法(fMRI:functional Magnetic Resonance Imaging)と頭蓋内電気生理学を使用して、脳の感情表現を分析した。また、日常生活を撮影した600万の動画を分析して各国の文化を越えて感情を推測してきた。その論文は国際的な週刊科学ジャーナル「Nature」に発表された。

コーウェン氏は、他の企業・団体の感情コンピューティング(Affective Computing)の研究も支援している。AIが偏りなく人の感情を認識できれば脅威はなくなり、心身ともに良好なウェルビーイング(幸福)な福祉社会の構築に貢献できると捉えている。その一方で、感情AIには課題があることも認識し、倫理的な対策について研究するNPO組織「The Hume Initiative」を立ち上げ、感情AIに伴う倫理的な課題についても研究している。

メンバーには、感情AIの研究者のほか、その倫理や心理学に関する専門家らが参画している。例えば、共感型AIを追求するGoogle Empathy Lab(2015年設立)の創設者であるダニエル・クレテック(Danielle Krettek) 氏やアルゴリズム公平性の専門家であるカーシック・ディナカ(Karthik Dinakar)氏、ヒューストン大学ソーシャルワーク大学院で勇気や心の弱さ、恥、共感などについて研究に携わっているブレネ・ブラウン(Brene Brown)氏、カリフォルニア大学バークレー校心理学教授でバークレイ・ソーシャル・インタラクション・ラボを統括するダッチャー・ケルトナー(Dacher Keltner)氏らが顔をそろえている。

研究成果のひとつとして、感情AIの開発や利用を進めようとしている企業や組織に向けた倫理ガイドライン(https://thehumeinitiative.org/guidelines/)を無料で公開している。

Hume AI は、2022年10月にニューヨークを拠点とする大規模医療ネットワークであるNorthwell Healthの投資部門であるNorthwell Holdingsを介して、300万ドルの資金を獲得した。この投資は、臨床研究、患者スクリーニング、アクセシビリティ技術など、ヘルスケア向けのマシンラーニングモデルを改良するために活用する計画。

Northwell Holdingsは、2021年にスタートアップスタジオ(同時多発的に複数の企業を立ち上げる組織)のAegis Venturesと提携し、ヘルスケア領域におけるAIに焦点を当てたジョイントベンチャー「Upliv」を立ち上げている。

Uplivは、2023 年末までに 840 万ドルのシード資本(会社設立前後の資金)を受け取る予定で、女性のヘルスケアに焦点を当て、医師や看護師との遠隔医療相談、ヘルスコーチへのアクセス、処方箋、患者コミュニティを提供する予定。Hume AI は、このAegis Ventures からも 500 万ドルを調達している。

Northwell Holdingsは、2022年4月にヘルスケア領域におけるAIスタートアップの立ち上げを目的とした企業として、「Ascertain」も設立した。このほか、クラウド技術とAIによる管理ワークフローの自動化を徹底するため、Google Cloudとのパートナーシップも発表するなど、医療・デジタルヘルス分野への先端技術の導入に積極的な取り込みを続けている。

2022年3月11日から20日まで、米テキサス州オースティンで開催されたテックイベント「SXSW Conference & Festivals(SXSW:サウス・バイ・サウスウエスト)」=写真=において、Hume AIは、VC(ベンチャーキャピタル)投資家や専門家に対してプロダクトやサービスをプレゼンテーションする「SXSW Pitch Startup Event」に出場し、「Artificial Intelligence, Robotics & Voice」部門で優勝している。

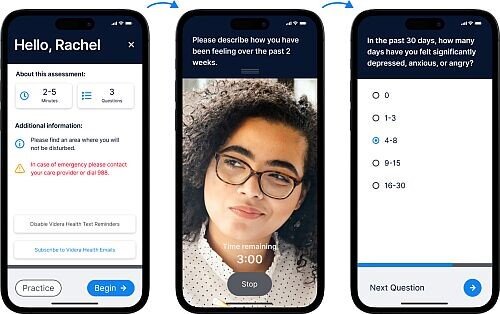

遠隔医療プラットフォームを提供するVidera Health

米ユタ州オレムに2019年に設立されたスタートアップのVidera Health (ビデラ・ヘルス)は、FDA(Food and Drug Administration:米国食品医薬品局)に登録済みの遠隔医療プラットフォームを=写真=提供している。これは、ビデオ分析と感情 AI を組み合わせて、メンタルヘルスの診断と治療をサポートする。初診から退院までの期間、いつでもどこでも患者と医療提供者を結びつけられる。新型コロナ感染症(COVID-19)のパンデミック以降、精神疾患も増加傾向にあり、医療スタッフと資金不足が深刻になっている。メンタルヘルスの医療提供者が不足するなか、医師がちょっとした手の空いた時間にも患者を診ることのできるスケーラブルな医療処置が求められている。

こうした中で、Videra Healthのシステムは、医療提供者と医療機関が、最も治療を必要としている患者をトリアージ(治療優先度選別)で特定し、ケアできるため導入が進んでいる。

従来は、多数の精神的な患者のメッセージを把握し、患者の感情を広範囲で捉えることはほぼ不可能だった。このシステム導入後は、患者が自分の好きな時間に、どこにいても医師とつながり、自分のデバイスで診療結果を受け取ることができるようになった。患者と医療従事者が離れていても、対話する機会が増えてコミュニケーションが強化された。

患者は、従来型の診断用の質問に答えるだけでなく、遠隔ビデオで受け答えすることで、プラットフォームが定量的にも定性的にも患者データを記録することになる。

システムに組み込まれたAIにより、患者の声、表情、動き、言語を分析することで、患者の病状を詳しく分析・洞察することができる。

AIによる分析・評価の結果は、臨床上の意思決定をサポートすることになる。患者の診断データは実用データに変換・記録され、患者にも配信される。

AIは、患者の危険な状態を感知すれば、警告を発し、早急な措置が必要な患者を見逃すことが低減できる。医療従事者は、警戒・注意が必要な患者についても警告を受けられるため、適切な患者を適切なタイミングで診察することができる。

それぞれの患者は、医師や看護婦と対面するのと同じように対話ができ、病状のデータを収集しながらも、患者と医師のエンゲージメントを向上させることができる。システムを導入している医療機関の調査では、患者のエンゲージメント率は最大 61%となり、熱心な患者ほど満足度が高く、症状の経過も良くなったという。

患者と医療従事者とのコミュニケーションは、遠隔ビデオだけでなく、電話、テキストメッセージ、ボイスメールも併用されている。医療側は、このシステムを利用することで、より多くの患者の診断・治療ができ、患者の定着率を向上させ、臨床スタッフの作業時間を節約できるようになっている。

Signature Healthcare Servicesと提携して患者をフォロー

Videra Healthは、2022 年 11 月に米カリフォルニア州に本拠を置く医療プロバイダーであるSignature Healthcare Servicesと提携して、感情AIを使用して患者の退院後のフォローアップの改善に努めている。

両社は、Signature Healthcare Servicesの主力施設であるヒューストン精神医療病院で、自動化されたビデオ退院後プログラムを実装している。導入後、短期間で効果が認められたため、残りの 18 の Signature Healthcare の施設にもサービスを拡大する計画。

Signature Healthcare Servicesは、米国最大規模の非営利の精神科・心療内科医療機関(病院)。コミュニティベースのヘルスケア配信システムを導入しており、低コストでありながら高品質のプライマリケア(総合医療)、専門ケア、病院ケア、関連する補助サービスを提供する。

Signature Healthcare を抱えるSignature Medical Group (SMG) は、米国で 19 の急性期医療施設(救急病院)で、メンタルヘルスと薬物乱用の治療をしている。150人超の医師グループがおり、ブロックトン病院看護学校を擁している。全施設は CMS (米国厚生省に属する公的医療保障制度運営主体)と 医療施設認定合同機構 (Joint Commission)によって認定されている。傘下には「オーロラ・ベハビオーラル・ヘルス(Aurora Behavioral Health)」 ブランドで多数の医療施設を運営している。

Videra HealthとSignature Healthcareのパートナーシップは、AI技術と信頼性のある行動医療システムを組み合わせることで、Signature Healthcareの医療機関において、小児、青年、成人、高齢者、居住患者向けに、急性期入院治療、部分入院、集中外来プログラムなど、あらゆる種類のプログラムを提供している。

患者の中には治療を途中でやめてしまい、健康を損なう人もいるため、いつでもどこでも患者とつなげられるVidera Health の遠隔医療プラットフォームを導入した。ビデオと音声をAIで分析して、患者がいつごろ苦痛を感じるようになり、サポートや介入が必要になるかを予測している。Signature Healthcareは、危険にさらされている患者を定期的に自動的にチェックイン(問題がないか確認)し、各患者に必要な退院後のフォローアップ、マイルストーン(到達段階のレベルごとの工程・節目)を順守することができるようになった。

全米では精神科の医療従事者も不足しており、精神治療の必要性がかつてなく高まっており、退院後の患者のケアへのアプローチも課題になっている。

そうした中で、Videra Healthのシステムは、従来よりも多数の患者に手が差し伸べられるだけでなく、自動化されたタッチポイント(顧客接点・患者との接点)により、患者に最初に治療を提供した同じ施設、同じプロバイダーにつなげ続けることができため、評価が高まっている。

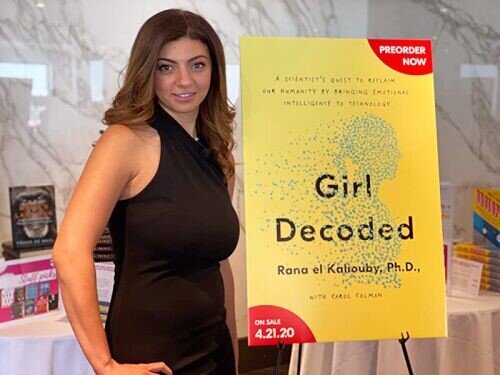

Affectiva 創設者で感情AI専門家のRana el Kaliouby氏を起用

Videra Health は、Peterson Ventures、Rose Park Advisors、OATV、Jeremy Andrus などの投資家から支援を受けるとともに、国際的に認められたヘルスケアとビデオ分析の専門家によって率いられている。その一環として、Videra Health は、2022 年 2 月 にAI研究者で起業家でもあるラナ・エル・カリウビー(Rana el Kaliouby)氏(博士)=写真=を取締役会に任命した。カリウビー氏は、スウェーデンのイェーテボリに本拠を置き、AIを搭載した視線計測システムを開発するSmart Eye の副 CEO(Deputy CEO)に就いている。書籍『Girl Decoded: A Scientist's Quest to Reclaim Our Humanity by Bringing Emotional Intelligence to Technology(解読された少女: 心の知能指数をテクノロジーに持たせることで人間性を取り戻すための科学者の探求)』を著している。Smart Eyeが、2021年5月に買収したAffectiva の共同創設者でもある。Affectiva は、2009年にMITメディアラボ(MIT Media Lab)のスピンアウトにより設立され、感情AI「Affdex(アフデックス)」の先進企業である。Affectiva の 感情AI は、グローバルで広告出稿をしている大企業の70% とともにFortune誌のグローバル 500 企業の 28% で使用されている。

すでにAffectiva は、10年以上の実績があるが、最近ではコミュニケーションによるエンゲージメントに力を入れ、付加価値を上げることを重視している。感情AIツールで、消費者の反応をつかむための「Conversational Engagement(会話エンゲージメント)」と 「Conversational Valence metrics(会話誘発性指標)」の機能を拡張し、より深い洞察を得られるようにして、「人間味」を強化している。

カリウビー氏は、Affectiva を設立する以前は、MIT メディアラボの研究・科学者であり、メンタルヘルスや自閉症の研究を含むさまざまな分野で感情AIの応用の先頭に立っていた。英ケンブリッジ大学で博士号を取得し、MIT(マサチューセッツ工科大学)でも博士号を取得した。

エンジェル投資家として、5000 万ドル以上の資金を調達し、非希薄化資金(株式総数の増加で1株あたりの価値が下がらない資金)をベンチャー企業に提供している。市場調査、自動車、健康などの多くの業界において、「人間認識 AI」と呼称している感情AIの開発と社会実装を促している。ハーバード・ビジネス・スクールのエグゼクティブ・フェロー。人間味のあるテクノロジー、AI の倫理、ダイバーシティを熱心に訴えている。

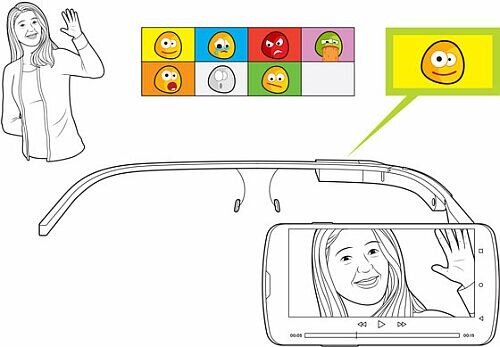

ARグラス「Google Glass」が自閉症の子どもに有効

感情AIの医療やヘルスケアへの応用に関連して、米スタンフォード大学はGoogle Glass=写真=を使い、自閉症スペクトラム障害 (ASD:Autism Spectrum Disorder)の子どもたちに行動療法を施す「Superpower Glass」という研究プロジェクトを、2015年から約6年間にわたり進めてきた。Google Glassは、Googleが2013年に「Glass Explorer」の仮称で開発したARスマートグラス。メガネ型の片側にプリズムディスプレイが装着され、求められる情報を表示することができる。

現在、一般向けの製品開発は終了しており、業務用途の「Glass Enterprise Edition 2(Google Glass EE2)」=写真=が2019年5月に発売され、物流、製造、工場、医療などの現場の効率化やエンゲージメントの強化に使われている。自閉症の子どもたちは、他人の顔から基本的な感情を認識できないため、Google Glassとマシンラーニング(機械学習)をベースとするAIを用いて、行動療法を施してきた。

このプロジェクトでは、Google Glassに取り付けられた外向きのカメラを使い、子どもと家族とのコミュニケーションを記録し、アルゴリズムにより自動検出された顔から感情を読みとり、Google Glassのディスプレイに絵文字や顔文字、テキスト(言葉)で表示する。同時に、内蔵された骨伝導トランスデューサー(スピーカー)から穏やかに音声の説明が入る。認識できるのは、「幸福」「怒り」「驚き」「悲しみ」「恐怖」「嫌悪」「軽蔑」の7種類の感情=写真=。子どもたちがGoogle Glassに慣れるために、他人に幸福の感情を引き出そうとさせる「Capture the Smile」のほか、人びとが表現する感情に名前をつける「Guess the Emotion」という2つのゲームを収録している。子どもたちは、Google Glassを常時装着しているのではなく、20分程度のセッションを週に数回程度実施する形態。約6週間継続するプログラムとなっており、これにより子どもは社会的パートナーの感情の読み取り方を習得できるという。

その介護にあたる家族には、システムを管理できるスマートフォン向けコンパニオンアプリが提供され、子どもがどういう行動をとっているのかを動画で確認することができる。上手にコミュニケーションができなかったときには、何を見ていたのか、何を感じ取ったのかが分かり、フィードバックするようになっている。

この研究には、6 歳から 12 歳までの自閉症 の子どもたち 71 人が参加した。参加者は自宅で週に 2 回 ABA(Applied Behavior Analysis:応用行動分析)療法を受ける。この研究に参加するために、子どもたちには事前にソーシャル・コミュニケーション・アンケートを実施し、そこで一定の点数(15 点以上)をとっている子どもが対象となった。

その中から、40人の子どもが無作為に選ばれて、Google Glassの研究グループに割り当てられた、残りの31人は、それとは関係のないグループに割り当てられ、その差異をテストした。提供されたソフトウェアは、音声から感情的な識別をし、顔文字を使用して介護者の感情が推測できるツールとゲームなどのフリープレイといった3つのエンゲージメント・アクティビティ・モードからなっている。

Google Glassの研究グループの子どもたちは、3 モードのソフトウェアツールのそれぞれを少なくとも 1 回使用するように促され、家族と週3 回、ABA 医師とは週に1 回、Google Glassを装着して 20 分間対話するようにした。

プロジェクトの実験結果を見ると、Google Glassを使用した子どもたちは、適応行動を評価する検査であるバインランド適応行動規準(Vineland Adaptive Behavior Scales Second Edition )のスコアが大幅に改善され、治療効果があったことが確かめられた。しかし、1 人の子どもについては、Google Glassに対して抵抗反応が報告されている。

米マサチューセッツ州シェフィールドのNPO法人であるAutism Treatment Centers の調査によれば、米国における子どもの自閉症の発症率は、2000年に150人に1人だったものの、2022年には44人に1人と急増しており、いまや約680万人の子どもや成人が自閉症を患っている。この病気の治療法はほとんどなく、わずかな投薬治療とABAプログラムしかない。自閉症患者のための施設やセラピストによる在宅セラピーが提供されるにとどまっている。

自閉症は、遺伝的要因が複雑に関与して起こる先天性の脳機能障害。対人関係やコミュニケーションの不得手、興味や活動のパターン化といった症状があり、幼児期では他人に関心を持たない、一人遊びが多い、人のまねをしない、落ち着きがないといった様相が見られる。こうした症例の改善に、ARスマートグラスが一定の効果があることが認められた。

Envisionは目の不自由な人向けのスマートグラスを開発

オランダのスタートアップのEnvision Technologiesは、Google Glass EE2をベースにして、改良型の目の不自由な人向けのスマートグラス「Envision Glasses」=写真=を開発・提供している。このARグラスにはAIが搭載され、60言語で印刷された文字、手書き文字を含む、さまざまな文字や文章をスキャンして読み上げたり、ビデオ通話ができたり、周囲の環境を装着者に言葉で説明したり、顔認証で友人や知人を判断することができる。小型カメラが物体や人、テキストをスキャンし、内蔵の小型スピーカーで情報を伝えることもできる。音声は右側の黒い筐体(きょうたい)からモノラルで聴こえ、ワイヤレスで音楽プレイヤーとも接続できる。

文字の読み取りができるOCR(Optical Character Recognition/Reader:光学的文字認識)機能は高精度のデバイス専用のアプリで、本や印刷物も読み上げてくれる。

部屋にあったり、周囲に動かないであるものだけでなく、動いていたり、近づいてくる車や人も通知してくれる。洗濯物などの色の判別をして仕分けができるようにしたり、部屋の明かりが点灯しているかも検知できる。

Envision Glassesは、800万画素の広角カメラを搭載し、Wi-FiとBluetoothのワイヤレス接続ができ、USB-Cでフル充電すれば5~6時間の使用が可能。

価格は2999 ユーロ(1ユーロは約145円換算で約43万4855円)。度付きレンズのメガネと合体させることができる。その場合は399ユーロ(5万7855円)の追加料金がかかる。

Envision は、2018 年にスマートフォンアプリの開発会社として設立。2020年にEnvision Glassesの開発をスタートした。2022年初めにソフトウェアの大幅なアップグレードを実施し、使い勝手を向上させた。随時、アップデートは続けており、機能も追加していくとしている。

救急医療の現場でも活用されるGoogle Glass

スタンフォード大学やEnvisionの事例のほかにも、Google Glassの医療やヘルスケアへの導入は広がっている。手軽にビデオ通話もできるため、リモート医療や患者の見守りにも役立っている。

スタンフォード大学医療センターの胸部外科(心臓・大動脈・肺・食道といった胸腔内臓器の疾患を扱う)では、レジデント・トレーニング・プログラムで Google Glass を導入している。医療センターの外科医は、Google Glass認定パートナーであるCrowdOpticsの技術を使用して、医学生や研修医が外科手術のトレーニングを施している。医学教育サービスのNational Bioskills Laboratoriesと提携している CrowdOptics ソフトウェアを使用すると、外科医は研修医の進行状況を観察でき、外科手術に関する視覚的なフィードバックを提供できる。これにより、手術の技の向上に欠かせない外科医と研修医とのコミュニケーションを円滑にしている。

Philips Healthcare は Google Glass を使用して、リアルタイムのモニタリング・サーベイランス機能と臨床的な意思決定支援ツールを組み合わせた「Philips IntelliVue」ソリューションを提供している。これを用いると、医師が手術中に患者から目を離すことなく、そのバイタルサインを看視できるようにしている。臨床医の視野に、患者の情報がオーバーレイして映し出される。また、教育用のアプリを使えば、手術手順のライブストリーミングが見られるため、研修医の訓練にも役立っている。

救急医療のMedEx Ambulance Service は、シカゴの Advocate Illinois Masonic Medical Center と提携し、救急車にGoogle Glass を導入している。これにより、救急・応急現場においてトリアージを実施し、急性脳卒中や心臓発作、外傷を評価する。救急車のEMT (Emergency Medical Technician:救急救命士)と救急隊員は、待機中の緊急治療室の医師に、現場から画像とビデオをストリーミングして、病院に到着する前に外傷を確認できるようになった。また、ロードアイランド病院では、ER(Emergency Room:救急室、救急外来)の医師が Google Glass を使用して、火傷や発疹のある患者をオフサイトの皮膚科医に相談している。

COVID-19のパンデミック以降、医師がオンラインで遠隔地の患者を診断する遠隔医療や遠隔健康診断が急増した。こうした中で、Google GlassはAIによる診断やビデオ・インタラクションを組み合わせて、過疎地域の患者と都市部の医療センターの医師を結びつける役割を果たすようになっている。

<つづく>

(清水メディア戦略研究所 代表)